Hoe één experiment tot 70 verschillende conclusies kan leiden

-

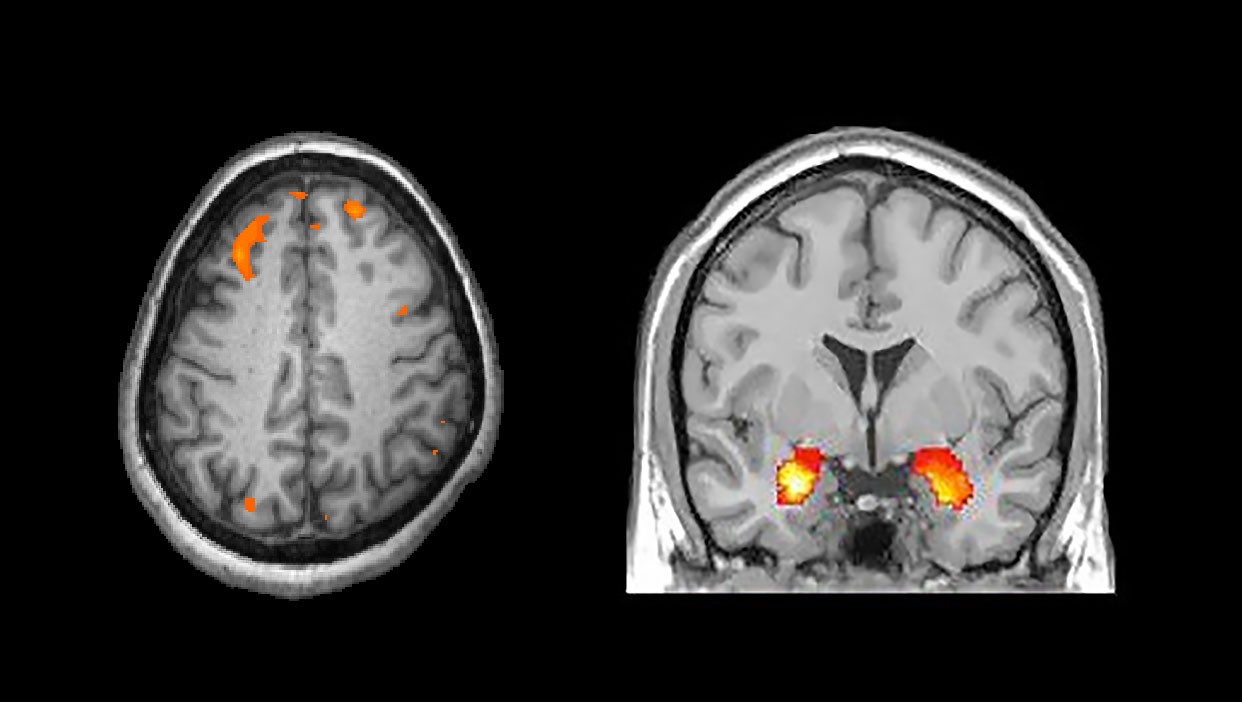

Een MRI-scanner op het Donders Instituut (niet betrokken bij de Nature-studie). Foto: Rein Wieringa

Een MRI-scanner op het Donders Instituut (niet betrokken bij de Nature-studie). Foto: Rein Wieringa

Een grote neuroimaging-studie in Nature heeft een flinke steen in de vijver gegooid: de vrijheid die onderzoekers hebben in hun analyses bepaalt sterk welke conclusies de neurowetenschappers trekken uit een experiment.

Het klinkt als een grap onder wetenschapsnerds: Wat gebeurt er als je zeventig hersenonderzoekers conclusies laat trekken uit dezelfde data? Ze worden het niet eens! In werkelijkheid is dit echter geen slechte grap, maar de bevinding van een publicatie afgelopen maand in toptijdschrift Nature.

De studie doet veel stof doet opwaaien onder wetenschappers omdat ze raakt aan de zogeheten replicatiecrisis binnen de sociale en medische wetenschappen. De afgelopen jaren bleken veel opzienbarende onderzoeksresultaten (zoals ‘tweetalige mensen kunnen zich beter concentreren’ of ‘rode wijn is goed voor de gezondheid’) tijdens herhaalonderzoek niet bevestigd te kunnen worden. Het toonde de noodzaak aan van het herhalen van experimenten en van betrouwbare analysemethodes.

Gokspel

De betrouwbaarheid van analysemethodes blijkt nu bij hersenonderzoek ook ondermaats, blijkt uit de nieuwe Nature-studie. De auteurs, onder aanvoering van promovenda Rotem Botvinik-Nezer van de Universiteit van Tel Aviv, lieten zeventig onderzoeksgroepen wereldwijd één en dezelfde set gegevens analyseren. De simpele vraag die ze stelden was: geef voor negen hypotheses aan of de gemeten hersenactiviteit er bewijs voor levert.

Het experiment zelf was simpel. Via een soort gokspel in een MRI-scanner konden 108 proefpersonen geld verdienen of juist verliezen. De hypotheses gingen over de vraag wat er tijdens zo’n taak gebeurt in de hersenen. Een voorbeeld: geldverlies zorgt voor een toename in de hersenactiviteit in de amygdala, een emotiegebied.

De uitkomsten van de zeventig deelnemende groepen varieerden sterk. Slechts over vier van de negen hypotheses was men het onderling enigszins eens. Één hypothese werd door ruim 84 procent van de onderzoekers bewezen geacht, en drie werden door nagenoeg iedereen (bijna 95 procent) verworpen. Voor de andere vijf stellingen waren de meningen verdeeld.

‘Landmark study’

De grote onenigheid verbaast methodoloog John Ioannidis niet, laat hij desgevraagd weten per mail. Ioannidis is hoogleraar gezondheidswetenschappen bij Stanford University en publiceerde meerdere invloedrijke artikelen op het gebied van onderzoeksmethodologie en over de replicatiecrisis. Zijn beroemdste publicatie, ‘Why most published research findings are false’, uit 2005, is het meest geciteerde artikel van vakblad PLoS Medicine.

Ioannidis noemt het recente Nature-artikel een ‘landmark study’. ‘Bij MRI-data moet je veel beslissingen maken tijdens het analyseproces’, mailt hij. ‘Daardoor kunnen zelfs doorgewinterde wetenschappers op basis van dezelfde data tot verschillende conclusies komen.’

Die beslissingen gaan over vragen als: wanneer heeft een proefpersoon te veel bewogen om nog zinvolle gegevens op te leveren? Hoe groot is het hersenoppervlak waarvan je de meetwaardes combineert? Bij welke statistische grenswaarde noem je hersenactiviteit ‘significant’? Geen twee groepen maken hierbij exact dezelfde keuzes, blijkt uit het Nature-artikel.

Affaire-Stapel

Zijn nu dus ook de meeste resultaten uit de neurowetenschappen fout? Nee, lacht Xiangzhen Kong van het Nijmeegse Max Planck Instituut. De onderzoeker was betrokken bij één van de zeventig analyses en een van de co-auteurs van de Nature-publicatie. ‘Er is nu eenmaal geen ‘beste’ analysemethode bij dit soort complexe data’, legt hij uit aan de telefoon.

Wat hem betreft is de studie vooral een voorbeeld van hoe je transparantie en reproduceerbaarheid van breinonderzoek kunt bevorderen. ‘Het moet bijvoorbeeld normaler worden dat onderzoekers alle data en analysecode delen.’ Samen met de andere Nature-auteurs pleit hij er bovendien voor dat wetenschappers vooráf al vastleggen welke analysestappen ze exact van plan zijn uit te voeren, een zogeheten preregistratie.

Controle van gepubliceerde resultaten is nu meestal nog lastig. Vaak bevatten neurowetenschappelijke artikelen maar summiere beschrijvingen van de onderzoeksmethodes. Dat maakt het bijna onmogelijk om experimenten en analyses exact te herhalen, en kan fraude in de hand werken – denk aan de affaire-Stapel.

Kong vindt het niet verrassend dat er onduidelijkheid is over meer dan de helft van de hypotheses. Volgens hem betekent dit dat het hersensignaal in die gevallen waarschijnlijk net rond de detectiegrens zat. Alsof je erachter probeert te komen of iemand nu wel of niet iets tegen je zegt op een feestje met veel geroezemoes.

‘De oplossing daarvoor is dat je beter moet nadenken over hoe je experimenten opzet, zoals door meer proefpersonen te onderzoeken. Daarom ben ik er ook voorstander van dat groepen meer gaan samenwerken, dan krijg je een grotere sample size. Zo kun je betrouwbaardere conclusies trekken.’

‘Neurowetenschappers kunnen fouten maken. Dat is geen baanbrekende conclusie’

Een te kleine groepsgrootte was in het verleden vaak een zorgenkind bij neuroimaging-studies, beaamt psycholoog Fred Hasselman. ‘Maar deze dataset bestond uit 108 deelnemers. Dat doet vermoeden dat ook andere oorzaken een rol kunnen spelen.’ Hasselman is universitair docent bij Sociale Wetenschappen en coördineerde twee jaar geleden een grote studie waarbij 28 psychologische experimenten elk zestig keer herhaald werden, om de betrouwbaarheid van hun resultaten te toetsen.

Grote individuele verschillen tussen proefpersonen zou een van die andere oorzaken kunnen zijn volgens Hasselman. ‘Die maken de interpretatie van neuro-imaging resultaten lastig, liet een onderzoeksgroep van het Donders Instituut onlangs nog zien. En uit Nijmeegs gedragsonderzoek weten we dat er inderdaad veel variatie in gedrag is bij de taak die proefpersonen in het Nature-experiment uitvoerden.’

Niet overtuigd

Niet iedereen is even onder de indruk van de Nature-studie. ‘De verschillen in uitkomsten laten wat mij betreft vooral zien dat de aannames die sommige groepen deden in hun analyses onjuist waren’, zegt Ivan Toni van het Donders Centre for Cognitive Neuroimaging, die zelf niet bij het onderzoek betrokken was.

Dit soort aannames gaat onder andere over welk deel van het meetsignaal ‘ruis’ is, bijvoorbeeld veroorzaakt door hoofdbewegingen in de scanner. Houd je daar onvoldoende rekening mee, dan kun je onjuiste conclusies trekken. Toni: ‘Neurowetenschappers kunnen fouten maken, maar dat is niet de baanbrekende conclusie die ik van een Nature-artikel had verwacht.’

De hoogleraar vindt het niet verstandig om elk onderzoeksresultaat systematisch door meerdere groepen opnieuw te laten analyseren, zoals de Nature-auteurs voorstellen. ‘Ten eerste doet het wetenschappelijke proces dat in zekere zin al via het peer-review-systeem,.’

Ten tweede lijkt het hem efficiënter om de nu eenmaal beperkte geldmiddelen uit te geven om wetenschappers goed op te leiden. ‘Zo leren ze hoe ze degelijke analyses op moeten zetten en kunnen ze ook beter fouten opsporen in de analyses van collega’s.’